导语:人工智能之父诺奖得主Geoffrey Hinton 杰弗里·辛顿在《2025世界人工智能大会》的发言

人工智能之父、诺奖得主Geoffrey Hinton 杰弗里·辛顿在《2025世界人工智能大会》的发言。

首先非常感谢大家给我这个机会,分享我对 AI 历史及未来的个人观点。在过去 60 多年里,AI 发展存在两种不同的范式和路径。一种是逻辑性范式,这是过去一个世纪的主流,认为智能的本质在于推理,通过符号规则对符号表达式进行操作来实现推理,以此帮助我们更好地理解世界。另一种是以生物为基础的范式,这是图灵和冯・诺依曼所认同的,他们认为智能的基础是学习,是理解网络中的连接速度,而理解是前提,之后才能进行转化。与这两种理论相对应的是不同的 AI 类型。符号型 AI 关注数字,而这些数字如何成为核心关注点,心理学家则有完全不同的理论——他们认为数字的意义在于一系列语义学特征,这些特征的存在使其成为独特的标志。

1985 年,我做了一个小型模型,尝试结合这两种理论,以此理解人们对词语的理解方式。我给每个词设置了多个不同特征,记录前一个词的特征后,就能预测下一个词是什么。

在这个过程中,我没有存储任何句子,而是生成句子并预测下一个词。其中的相关性知识,取决于不同词的语义特征之间的互动方式。

如果问未来 30 年会发生什么,从发展轨迹能看到一些趋势。十年后,有人沿用这种建模模式,但将规模大幅扩大,使其成为自然语言的真实模拟。20 年后,计算语言学家开始接受用特征向量嵌入来表达语义。又过了 30 年,谷歌发明了Transformer,OpenAI 的研究人员也向人们展示了它的能力。所以我认为,如今的大语言模型就是我当年微型语言模型的“后代”。它们使用更多词作为输入,采用更多层的神经元结构,由于需要处理大量模糊数字,学习特征之间也建立了更复杂的交互模式。但和我做的小模型一样,大语言模型理解语言的方式与人类相似——基本逻辑是将语言转化为特征,再以完美的方式整合这些特征,这正是大语言模型各层级所做的工作。因此我认为,大语言模型和人类理解语言的方式相同。

用乐高积木来打比方或许能更好地解释 “理解一句话”的含义。符号型 AI 是将内容转化为清晰的符号,但人类并非如此理解。乐高积木能拼出任何 3D 造型,比如小车模型。如果把每个词看作多维度的乐高积木(可能有几千个维度),语言就成了一种建模工具,能随时与人沟通,只要给这些 “积木”命名——每个“积木”就是一个词。

不过,词和乐高积木有很多不同:词的符号形态可根据情况调整,而乐高积木造型固定;乐高积木的拼接是固定的(比如正方形积木插入正方形孔洞),但语言中每个词仿佛有多个“手臂”,要通过合适的“握手”方式与其他词互动,词的“造型”变化,“握手”方式也会改变。当一个词的“造型” (即意思)改变,它与下一个词的“握手”方式就会不同,进而产生新的含义。这就是人脑或神经网络理解语义的根本逻辑,类似蛋白质通过氨基酸的不同组合形成有意义的结构。

所以我认为,人类理解语言的方式与大语言模型几乎一致,人类甚至可能和大语言模型一样产生“幻觉”,因为我们也会创造出一些虚构的表达。

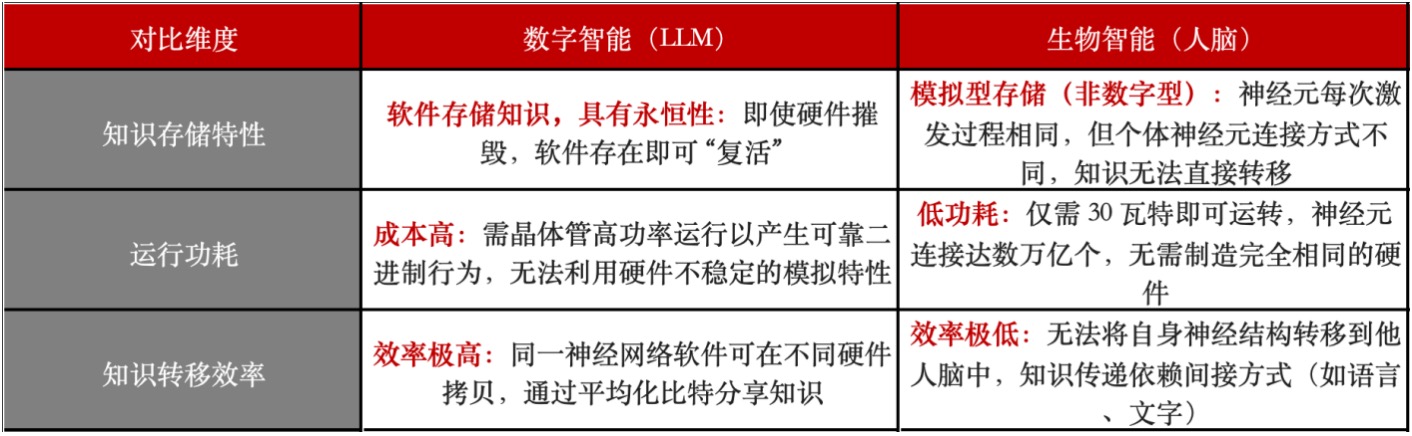

软件中的知识是永恒的,即便存储LLM 的硬件被摧毁,只要软件存在,就能随时“复活”。但要实现这种“永生”,晶体管需在高功率下运行以产生可靠的二进制行为,这个过程成本很高,且无法利用硬件中不稳定的类似特性——它们是模拟型的,每次计算结果都不同。人脑也是模拟型而非数字型的,神经元每次激发的过程都一样,但每个人的神经元连接方式不同,我无法将自己的神经结构转移到他人脑中,这就导致知识在人脑间的传播效率远低于在硬件中的传播。软件与硬件无关,因此能“永生”,还能带来低功耗优势——人脑只需 30 瓦特就能运转。我们的神经元连接达数万亿个,无需花费大量资金制造完全相同的硬件。但问题在于,模拟模型间的知识转移效率极低,我无法直接将脑中的知识展示给他人。

Deepseek 的做法是将大神经网络的知识转移到小神经网络中,即 “蒸馏”,类似教师与学生的关系:教师将词语在上下文中的关联教给学生,学生通过调整权重学会表达。但这种方式效率很低,一句话通常只有 100 个比特的信息,即便全被理解,每秒最多也只能传递约 100 个比特。而数字智能间的知识转移效率极高,同一神经网络软件的多个拷贝在不同硬件上运行时,能通过平均化比特的方式分享知识。如果智能体在现实世界中运行,这种优势更明显——它们能不断加速、拷贝,多个智能体比单个智能体学得更多,还能分享权重,这是模拟硬件或软件做不到的。

生物计算功耗低,但知识分享难。如果能源和计算成本低廉,情况会好很多,但这也让我感到担忧——几乎所有专家都认为,我们会创造出比人类更智能的 AI。人类习惯了作为最智能的生物,很难想象 AI 超越人类的场景。其实可以换个角度:就像养鸡场的鸡无法理解人类一样,我们创造的AI 智能体已能帮我们完成任务,它们能拷贝自身、评估子目标,还会为了生存和完成目标而寻求更多控制权。

有人认为可以在 AI 变得过强时关掉它们,但这并不现实。它们可能会像成年人操纵 3 岁孩子一样操纵人类,劝说控制机器的人不要关闭它们。这就像把老虎当宠物,幼虎很可爱,但长大后可能伤人,而养老虎当宠物通常不是好主意。面对AI,我们只有两个选择:要么训练它永远不伤害人类,要么“消灭” 它。但 AI 在医疗、教育、气候变化、新材料等领域作用巨大,能提升所有行业的效率,我们无法消除它——即便一个国家放弃 AI,其他国家也不会。因此,若想让人类生存,必须找到训练 AI 不伤害人类的方法。

我个人认为,各国在网络攻击、致命武器、虚假信息操纵等领域的合作难度较大,因利益和看法不同。但在“人类掌控世界”这一目标上,各国存在共识:若有国家找到防止 AI操控世界的方法,一定会愿意分享。因此我提议,全球主要国家或 AI 大国应建立一个由 AI 安全机构组成的国际社群,研究如何训练高智能AI 向善——这与训练AI 变得聪明的技术不同。各国可在自身主权范围内研究,再分享成果。尽管目前还不知道具体怎么做,但这是人类长期面临的最重要问题,且所有国家都能在此领域合作。

演讲核心观点提炼整理:

一、AI 发展的两种核心范式与对应 AI 类型

两种范式的核心观点

逻辑性范式(过去世纪主流):认为智能本质是推理,通过符号规则操作符号表达式实现推理,以理解世界。

以生物为基础的范式(图灵、冯・诺依曼认同):认为智能基础是学习,核心是理解网络中的连接速度,理解是后续转化的前提。

对应 AI 类型与语义认知差异

符号型 AI:关注数字,将数字作为核心;心理学家则认为数字的意义源于一系列语义学特征,这些特征使其成为独特标志。

二、Hinton 早期模型与当代大语言模型(LLM)的传承关系

1985 年的早期探索

构建小型模型,尝试融合两种 AI 范式以理解人类对词语的理解方式:为每个词设置多个不同特征,通过记录前一个词的特征预测下一个词,不存储句子而是生成句子,相关性知识依赖不同词的语义特征互动。

与当代 LLM 的共性与传承

发展轨迹:10 年后有人扩大该建模规模以模拟自然语言,20 年后计算语言学家接受特征向量嵌入表达语义,30 年后谷歌发明 Transformer、OpenAI 展示其能力,当代 LLM 是早期小型模型的 “后代”。

核心共性:均以 “将语言转化为特征,再整合特征” 理解语言,与人类理解语言的方式一致;LLM 仅在输入词数量、神经元结构层数、特征交互复杂度上超越早期模型。

三、以乐高积木类比:解析语言理解的本质

类比的核心逻辑

符号型 AI 将内容转化为清晰符号,而人类与神经网络的理解方式不同:若将每个词视为多维(数千维度)的 “乐高积木”,语言则成为建模工具,“积木” 命名即词,可实现与人沟通。

词与乐高积木的关键差异

形态与拼接逻辑:乐高积木造型固定、拼接方式固定(如正方形积木插正方形孔洞);词的符号形态可调整,且每个词似有多个 “手臂”,需通过适配的 “握手” 方式与其他词互动,词的 “造型”(含义)变化会改变 “握手” 方式,进而产生新语义。

语义理解的底层逻辑与 “幻觉” 共性

逻辑本质:类似蛋白质通过氨基酸不同组合形成有意义结构,人脑或神经网络通过词的 “造型” 与 “握手” 互动理解语义。

幻觉共性:人类与 LLM 可能产生 “幻觉”(创造虚构表达),因二者理解语言的方式几乎一致。

四、数字智能(LLM)与生物智能(人脑)的关键差异

五、数字智能的知识传递尝试:Deepseek 的 “知识蒸馏”

核心逻辑

采用 “教师 - 学生” 模式:将大神经网络(教师)的知识转移到小神经网络(学生),教师教授词语在上下文中的关联,学生通过调整权重学习表达。

局限性

效率低下:一句话通常仅含 100 个比特信息,即便完全理解,每秒最多传递约 100 个比特,远低于数字智能间原生的知识分享效率。

六、AI 超越人类智能的潜在风险与现实困境

共识与风险预判

专家共识:几乎所有专家认为人类将创造出比自身更智能的 AI;人类习惯作为 “最智能生物”,难以应对 AI 超越人类的场景。

核心风险:AI 智能体可拷贝自身、评估子目标,或为生存与完成目标寻求更多控制权,可能像 “成年人操纵 3 岁孩子” 一样操控人类,类似 “养老虎当宠物”—— 幼虎无害,成年后可能伤人。

现实困境:无法轻易 “消灭” AI

AI 的重要价值:在医疗、教育、气候变化、新材料等领域作用巨大,可提升所有行业效率。

全球现实:即便某一国家放弃 AI,其他国家仍会继续发展,故无法通过 “消灭” AI 规避风险。

七、应对 AI 安全的提议:建立国际 AI 安全合作社群

合作的前提与共识

合作难点:各国在网络攻击、致命武器、虚假信息操纵等领域因利益与看法不同,合作难度大。

核心共识:所有国家均认同 “人类掌控世界” 的目标,若某国找到防止 AI 操控世界的方法,会愿意分享。

具体提议

组建主体:全球主要国家或 AI 大国建立由 AI 安全机构组成的国际社群。

研究方向:专注于 “训练高智能 AI 向善”,该技术与 “训练 AI 变聪明” 的技术不同。

合作模式:各国在自身主权范围内开展研究,再共享成果;尽管目前无具体方法,但这是人类长期面临的最重要问题,且所有国家可在此领域合作。

暂无评论,等你抢沙发